이글은 다음 문서를 참조합니다.

www.tensorflow.org/guide/keras/save_and_serialize

(번역은 자력 + 파파고 + 구글 번역기를 사용하였으니, 부자연스럽더라도 양해바랍니다.)

이번 가이드는 모델을 저장하는 방법과 serialization하는 방법을 다룹니다.

Part 1 : Saving Sequential models or Functional models

예제를 보곘습니다.

from tensorflow import keras

from tensorflow.keras import layers

inputs = keras.Input(shape=(784,), name='digits')

x = layers.Dense(64, activation='relu', name='dense_1')(inputs)

x = layers.Dense(64, activation='relu', name='dense_2')(x)

outputs = layers.Dense(10, activation='softmax', name='predictions')(x)

model = keras.Model(inputs=inputs, outputs=outputs, name='3_layer_mlp')

model.summary()훈련시킨 후 모델의 가중치와 optimizer state를 저장할 수 있습니다. 재미는 없지만 학습하지 않은 모델도 저장 가능합니다.

(x_train, y_train), (x_test, y_test) = keras.datasets.mnist.load_data()

x_train = x_train.reshape(60000, 784).astype('float32') / 255

x_test = x_test.reshape(10000, 784).astype('float32') / 255

model.compile(loss='sparse_categorical_crossentropy',

optimizer=keras.optimizers.RMSprop())

history = model.fit(x_train, y_train,

batch_size=64,

epochs=1)# Save predictions for future checks

predictions = model.predict(x_test)

Whole-model saving

빌드된 모델을 하나로 저장할 수 있습니다. 모델을 만든 코드가 더 이상 남아있지 않더라도 이 파일을 통해 다시 사용할 수 있습니다.

파일에는 다음 내용이 포함됩니다.

- 모델 구조

- weight values

- training config(compile)

- optimizer and state

# Save the model

model.save('path_to_my_model.h5')

# Recreate the exact same model purely from the file

new_model = keras.models.load_model('path_to_my_model.h5')

import numpy as np

# Check that the state is preserved

new_predictions = new_model.predict(x_test)

np.testing.assert_allclose(predictions, new_predictions, atol=1e-6)

# Note that the optimizer state is preserved as well:

# you can resume training where you left off.

Export to SavedModel

전체모델을 Tensorflow savedmodel format으로 추출할 수 있습니다. Tensorflow 객체용 독립형 serialization format이며 Python 이외의 Tensorflow 구현 뿐만아니라 Tensorflow Serving기능도 제공합니다.

# Export the model to a SavedModel

keras.experimental.export_saved_model(model, 'path_to_saved_model')

# Recreate the exact same model

new_model = keras.experimental.load_from_saved_model('path_to_saved_model')

# Check that the state is preserved

new_predictions = new_model.predict(x_test)

np.testing.assert_allclose(predictions, new_predictions, atol=1e-6)

# Note that the optimizer state is preserved as well:

# you can resume training where you left off.SavedModel은 다음을 포함합니다.

- model weights를 포함한 Tensorflow checkpoint

- Tensorflow graph가 포함된 SavedModel 프로토타입. 예측(Serving), 학습, 평가를 위한 별도의 그래프. 이전에 compile하지 않았다면, inference 그래프만 추출됨.

- 모델 구조

Architecture-only saving

weight나 optimizer는 관심이 없고, 오로지 모델 구조에만 관심이 가는 경우가 있습니다. 이러한 경우에 get_config()를 통해 모델의 config를 검색하면 됩니다. 같은 모델을 재생성할 수 있도록 파이썬 dict구조로 되어 있습니다. 이렇게 불러진 모델은 이전에 학습한 정보는 가지고 있지 않습니다.

config = model.get_config()

reinitialized_model = keras.Model.from_config(config)

# Note that the model state is not preserved! We only saved the architecture.

new_predictions = reinitialized_model.predict(x_test)

assert abs(np.sum(predictions - new_predictions)) > 0.python dict대신에 to_json(), from_json()을 사용하여 JSON으로도 저장할 수 있습니다. disk에 저장할 때 유용하게 사용됩니다.

json_config = model.to_json()

reinitialized_model = keras.models.model_from_json(json_config)

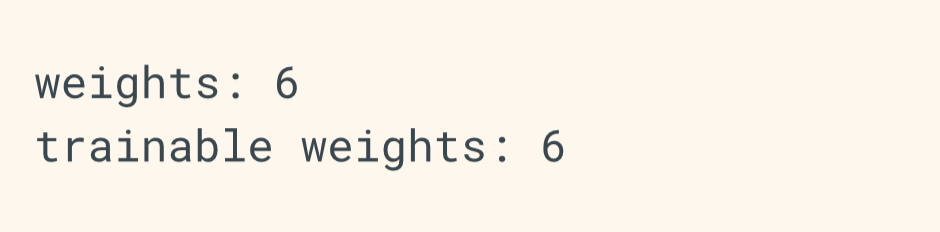

Weights-only saving

weights에만 관심이 있는 경우에 get_weights()를 사용하여 Numpy array로 이루어진 weights를 찾을 수 있습니다. 또한, 모델의 상태를 set_weights로 변경할 수 있습니다.

weights = model.get_weights() # Retrieves the state of the model.

model.set_weights(weights) # Sets the state of the model.get_config() / from_config() 와 get_weights() / set_weights()를 적절히 섞어 사용할 수 있습니다. 하지만, model.save()와는 다르게 이들은 학습 config와 optimizer를 포함하지 않습니다. 따라서 compile을 다시 설정해주어야 합니다.

config = model.get_config()

weights = model.get_weights()

new_model = keras.Model.from_config(config)

new_model.set_weights(weights)

# Check that the state is preserved

new_predictions = new_model.predict(x_test)

np.testing.assert_allclose(predictions, new_predictions, atol=1e-6)

# Note that the optimizer was not preserved,

# so the model should be compiled anew before training

# (and the optimizer will start from a blank state).get_weights() / set_weights()와 같은 의미이면서 디스크에 저장하려면 save_weighs(fpath) / load_weights(fpath)를 사용하면 됩니다.

# Save JSON config to disk

json_config = model.to_json()

with open('model_config.json', 'w') as json_file:

json_file.write(json_config)

# Save weights to disk

model.save_weights('path_to_my_weights.h5')

# Reload the model from the 2 files we saved

with open('model_config.json') as json_file:

json_config = json_file.read()

new_model = keras.models.model_from_json(json_config)

new_model.load_weights('path_to_my_weights.h5')

# Check that the state is preserved

new_predictions = new_model.predict(x_test)

np.testing.assert_allclose(predictions, new_predictions, atol=1e-6)

# Note that the optimizer was not preserved.이는 너무 복잡하니 다음과 같은 방법을 추천드립니다.

model.save('path_to_my_model.h5')

del model

model = keras.models.load_model('path_to_my_model.h5')

Weights-only saving in SavedModel format

save_weights는 keras에서 HDF5 format, Tensorflow에서 SavedModel format 형태를 만들어 냅니다. 이러한 형식은 사용자가 제공하는 되로 선택되어집니다. ".h5", "keras"인 경우는 Keras HDF5 형식을 사용합니다. 다른 모든 항목은 SavedModel로 기본 설정 됩니다.

model.save_weights('path_to_my_tf_savedmodel')명시적으로 save_format인자("tf" or "h5")를 전달하여 설정할 수 있습니다.

model.save_weights('path_to_my_tf_savedmodel', save_format='tf')

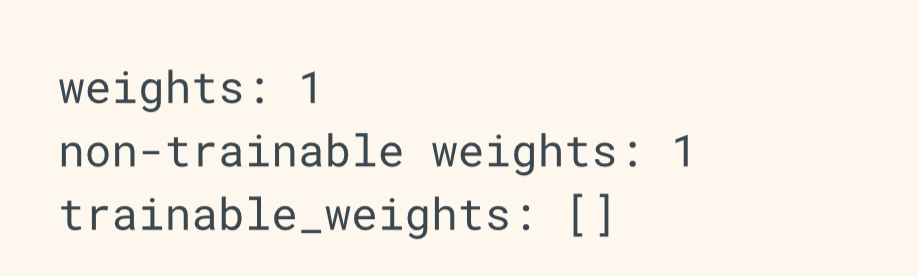

Saving Subclassed Models

Sequential, Functional Model은 DAG of layers를 나타내는 데이터구조입니다. 이들은 안전하게 serialized, deserialized될 수 있습니다.

subclassed되어진 모델은 데이터 구조가 아닌 그저 코드의 일부분일 뿐입니다. 이러한 모델의 구조는 call method에서 정의됩니다. 이는 모델이 안전하게 serialized될 수 없다는 것을 의미합니다.

모델을 불러오기 위해, 모델을 생성한 코드(the code of the model subclass)에 접근할 수 있어야합니다. 대신, 이러한 코드를 바이트코드(pickling)로 serializing할 수 있지만 안전하지 않습니다.

class ThreeLayerMLP(keras.Model):

def __init__(self, name=None):

super(ThreeLayerMLP, self).__init__(name=name)

self.dense_1 = layers.Dense(64, activation='relu', name='dense_1')

self.dense_2 = layers.Dense(64, activation='relu', name='dense_2')

self.pred_layer = layers.Dense(10, activation='softmax', name='predictions')

def call(self, inputs):

x = self.dense_1(inputs)

x = self.dense_2(x)

return self.pred_layer(x)

def get_model():

return ThreeLayerMLP(name='3_layer_mlp')

model = get_model()우선, 한번도 사용되지 않은 모델은 저장할 수 없습니다.

subclassed model은 weights를 생성하기 위해 한번쯤은 데이터가 필요하기 때문입니다.

모델이 호출될 때 까지, input dtype, shape를 알 수 없고 weight variable또한 마찬가지입니다. Functional Model은 가장 처음에 keras.Input을 통해 input dtype, shape를 정의하기 때문에 이러한 문제가 없습니다.

(x_train, y_train), (x_test, y_test) = keras.datasets.mnist.load_data()

x_train = x_train.reshape(60000, 784).astype('float32') / 255

x_test = x_test.reshape(10000, 784).astype('float32') / 255

model.compile(loss='sparse_categorical_crossentropy',

optimizer=keras.optimizers.RMSprop())

history = model.fit(x_train, y_train,

batch_size=64,

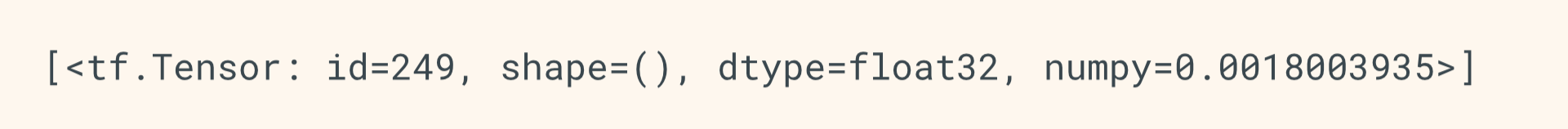

epochs=1)subclassed model을 저장하는데에 추천하는 방법은 model과 연관된 모든 variable을 담고있는 Tensorflow SavedModel checkpoint를 만드는 save_weights()를 사용하는 것입니다.(weights, optimizer state, etc.)

model.save_weights('path_to_my_weights', save_format='tf')

# Save predictions for future checks

predictions = model.predict(x_test)

# Also save the loss on the first batch

# to later assert that the optimizer state was preserved

first_batch_loss = model.train_on_batch(x_train[:64], y_train[:64])모델을 복원하기 위해선 만들어진 모델 객체에 접근할 수 있어야합니다.

metric, optimizer의 상태를 복원하려면 model을 compile하고 load_weights를 호출하기 전에 일부 데이터를 호출해야합니다.

# Recreate the model

new_model = get_model()

new_model.compile(loss='sparse_categorical_crossentropy',

optimizer=keras.optimizers.RMSprop())

# This initializes the variables used by the optimizers,

# as well as any stateful metric variables

new_model.train_on_batch(x_train[:1], y_train[:1])

# Load the state of the old model

new_model.load_weights('path_to_my_weights')

# Check that the model state has been preserved

new_predictions = new_model.predict(x_test)

np.testing.assert_allclose(predictions, new_predictions, atol=1e-6)

# The optimizer state is preserved as well,

# so you can resume training where you left off

new_first_batch_loss = new_model.train_on_batch(x_train[:64], y_train[:64])

assert first_batch_loss == new_first_batch_loss'# Machine Learning > TensorFlow doc 정리' 카테고리의 다른 글

| tf.data tutorial 번역 (1) (0) | 2020.02.14 |

|---|---|

| tensorflow 2.0 keras Write custom callbacks (2) | 2019.04.18 |

| tensorflow 2.0 keras Writing layers and models with tf keras (2) (0) | 2019.04.13 |

| tensorflow 2.0 keras Writing layers and models with tf keras (1) (0) | 2019.04.13 |

| tensorflow 2.0 keras Training and evaluation (4) (0) | 2019.04.12 |