Abstract

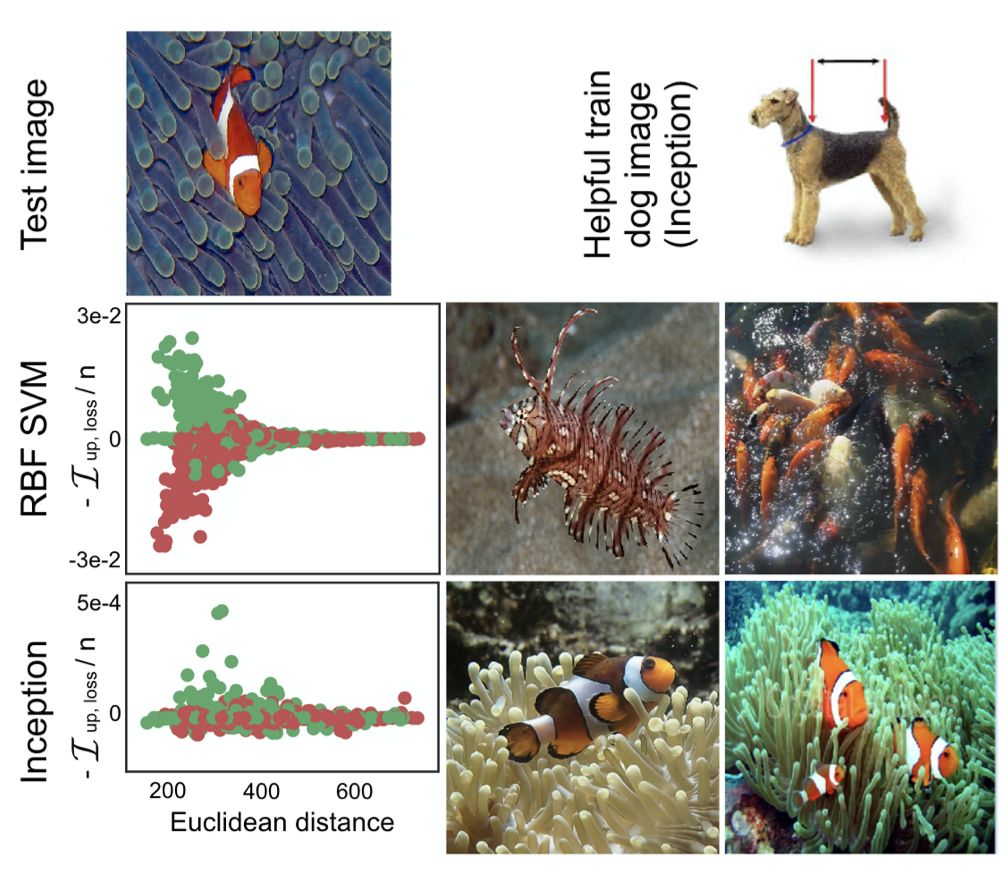

In this work we address the task of semantic image segmentation with Deep Learning and make three main contributions that are experimentally shown to have substantial practical merit. First, we highlight convolution with upsampled filters, or ‘atrous convolution’, as a powerful tool in dense prediction tasks. Atrous convolution allows us to explicitly control the resolution at which feature responses are computed within Deep Convolutional Neural Networks. It also allows us to effectively enlarge the field of view of filters to incorporate larger context without increasing the number of parameters or the amount of computation. Second, we propose atrous spatial pyramid pooling (ASPP) to robustly segment objects at multiple scales. ASPP probes an incoming convolutional feature layer with filters at multiple sampling rates and effective fields-of-views, thus capturing objects as well as image context at multiple scales. Third, we improve the localization of object boundaries by combining methods from DCNNs and probabilistic graphical models. The commonly deployed combination of max-pooling and downsampling in DCNNs achieves invariance but has a toll on localization accuracy. We overcome this by combining the responses at the final DCNN layer with a fully connected Conditional Random Field (CRF), which is shown both qualitatively and quantitatively to improve localization performance. Our proposed “DeepLab” system sets the new state-of-art at the PASCAL VOC-2012 semantic image segmentation task, reaching 79.7% mIOU in the test set, and advances the results on three other datasets: PASCAL-Context, PASCAL-Person-Part, and Cityscapes. All of our code is made publicly available online.

이 논문에서는 딥러닝에서의 의미론적 객체 분할 작업과 세 가지의 주요 기여에 대해 설명한다.

첫 번째, dense한 예측(예를 들면, pixel 단위의 예측)에서 강력한 도구인 'atrous convolution'을 강조한다.

Atrous Convolution은 깊은 합성곱 신경망에서 계산되는 특징 반응을 명확하게 제어할 수 있다.

또한, 계산량을 증가시키는 파라미터 수의 증가 없이 큰 맥락을 통합할 수 있는 필터의 관점을 효율적으로 크게 사용할 수 있다.

두 번째, 여러 크기로 객체를 견고하게 세분화 할 수 있는 ASPP(Atrous Spatial Pyramid Pooling)을 제안한다.

ASPP는 다중 샘플링 속도와 효율적인 FOV(Field of View)에서 필터를 사용하여 들어오는 컨볼루션 피처 레이어를 조사하며, 다양한 크기의 이미지 맥락뿐만 아니라 객체를 캡쳐할 수도 있다.

세 번째, DCNN과 확률적 그래프 모델을 방법을 결합하여 객체 경계의 제역화를 개선한다.

일반적으로 DCNN에서 다운샘플링과 맥스풀링의 조합은 불변성이라는 장점을 가지고 있지만, 지역화 정확도에 좋지 않다.

우리는 이러한 문제를 CRF(fully connected Conditional Random Field)를 사용하여 해결하려 한다.

우리가 제안한 'DeepLab' 시스템은 PASCAL VOC-2012에서 SOTA를 달성하였으며, PASCAL-Context, PASCAL-Person, Cityscapes에서 향상된 결과를 얻었다.

요약

- Semantic Segmentation에서 사용하는 대표적 평가 방법 IOU --> TP / (TP + FP + FN)

- atours convolution = Dilated convolution, 기존 컨볼루션에서 픽셀간 거리를 하나 띄워서 필터를 만드는 것

- 이들의 장점은 receptive field의 크기는 키울 수 있지만, 파라미터는 급격히 증가하지 않는다는 것이다.

- 확률적 그래프 모델은 CRF는 픽셀이 위치, RGB상으로 비슷한데 Label이 다르면 패널티를 주어 이를 최소화하게 한다. 자세한건 논문의 수식이나 PR12 동영상을 참고. 이를 사용하면 다음과 같이 객체의 경계를 자세하게 구분지을 수 있음

- dilated convolution을 사용하면 풀링을 사용하지 않아도 receptive field를 크게 가져가면서 좋은 성능을 얻을 수 있다. 이는 풀링의 장점 중 하나인 파라미터 감소의 효과도 있다.

- 제안한 ASPP는 Dilated Convolution만으로는 다양한 크기를 보기 힘들며, 이는 resolution(이미지 크기) 유지를 위해 사용한다. 따라서 우리는 Spatial Pyramid Pooling으로 다양한 input 크기를 다루어서 성능 향상을 꽤한다.

Reference

https://www.youtube.com/watch?v=JiC78rUF4iI&list=PLWKf9beHi3Tg50UoyTe6rIm20sVQOH1br&index=4

Chen, L. C., Papandreou, G., Kokkinos, I., Murphy, K., & Yuille, A. L. (2017). Deeplab: Semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected crfs. IEEE transactions on pattern analysis and machine intelligence, 40(4), 834-848.

'# Paper Abstract Reading' 카테고리의 다른 글

| Towards Principled Methods for Training Generative Adversarial Networks (0) | 2019.12.30 |

|---|---|

| Learning Deep Features for Discriminative Localization (0) | 2019.12.22 |

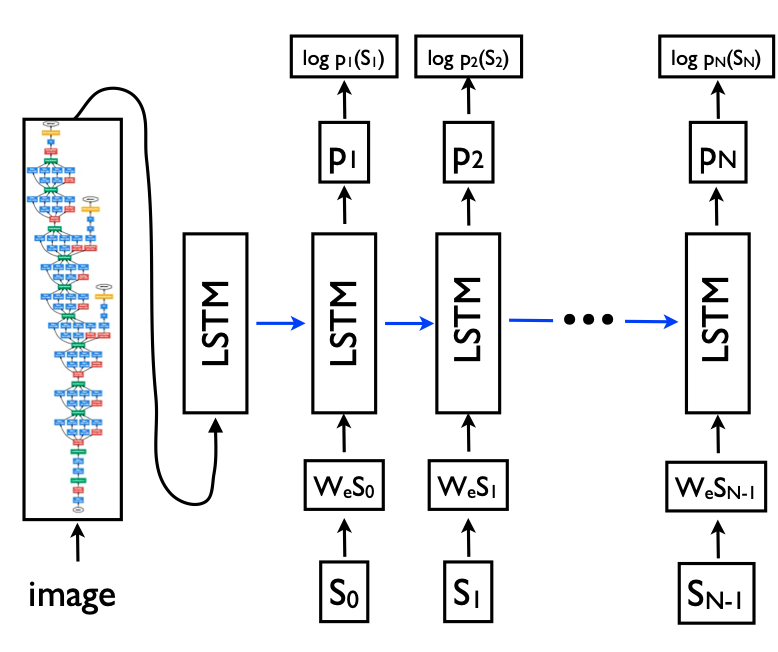

| Show and Tell: A Neural Image Caption Generator (0) | 2019.12.13 |

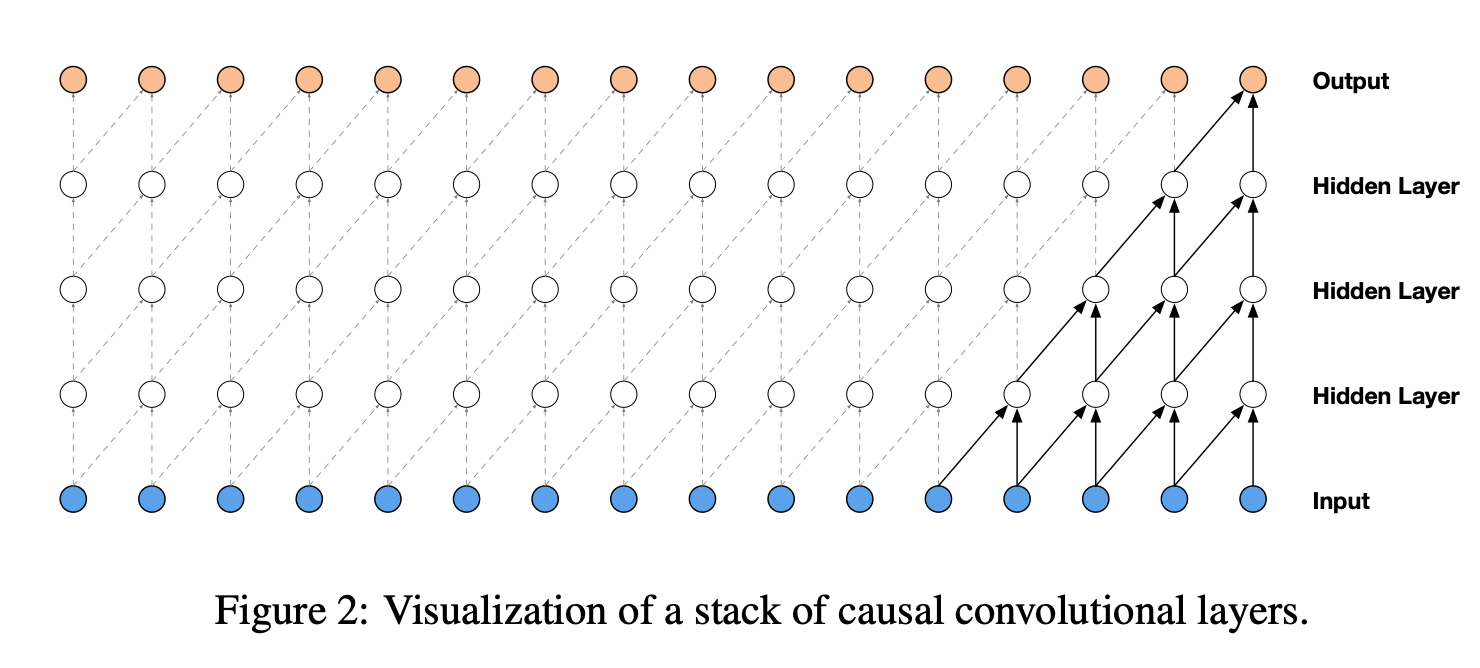

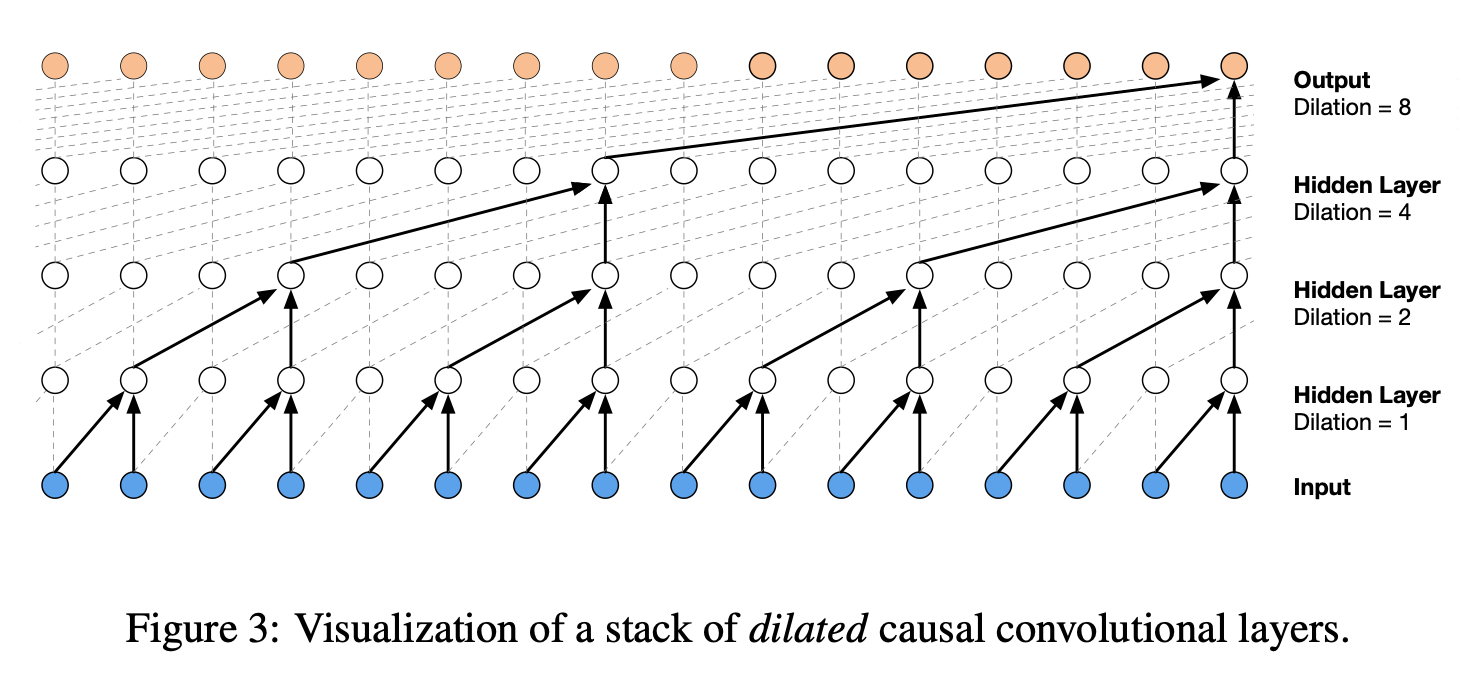

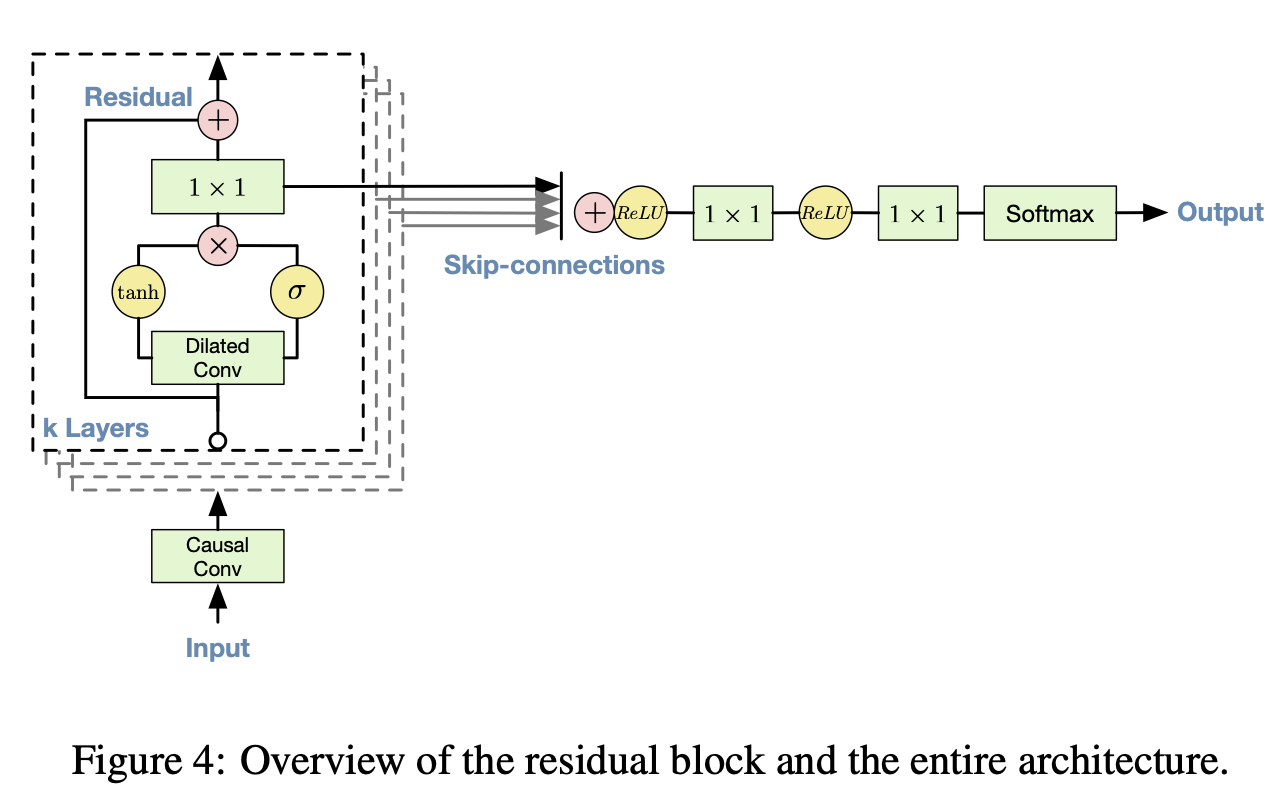

| WaveNet - A Generative Model for Raw Audio (0) | 2019.12.07 |

| Learning to Remember Rare Events (0) | 2019.12.02 |